N’en déplaise aux anciens, l’informatique moderne est née dans les années 80. Avant cela, le domaine s’apprenait à l’université et ne s’appliquait qu’à l’échelle d’une société. Alors la voir débarquer dans les foyers, même sous une forme peu performante et très simplifiée, c’était un nouveau monde qui apparaissait dans une simple boîte.

Cette décennie a vu des philosophies s’affronter. Le prix a été un élément discriminant. Acheter un ordinateur peu cher et se priver de fonctionnalités utiles à l’usage ou s’investir pour des années sur un équipement rapidement dépassé mais avec des périphériques utiles à son usage.

Le deuxième schisme, autour du processeur, aurait pu changer la face du monde. Débat technique mais crucial. L’architecture CISC (le processeur, µp, comprend beaucoup d’instructions mais lentement) n’avait d’intérêt que pour des universitaires et des chercheurs. Son concurrent, le RISC se révélait plus performant et moins cher.

Pourquoi embarquer des instructions complexes ? Personne ne parle le langage machine. Et le compilateur traduit le programme de manière optimale, quelque soit l’architecture cible. Mais l’hégémonie du PC a été en faveur de l’architecture CISC. Il faudra attendre 20 ans pour que l’architecture concurrente retrouve le grand public.

Un autre élément de discorde était l’absence de compatibilité entre les marques. Si les compatibles PC étaient une exception, les passerelles entre Mac et PC étaient hors de prix. Et les guerres de clans, Atari vs Amiga, laissaient peu d’espoir à la mise en commun de savoir.

L’absence de compatibilité se trouvait aussi dans les langages de programmation. Les Basic présents dans les différentes machines étaient souvent incompatibles entre eux. Cela n’interdisait pas un peu de recherche pour traduire un programme d’une plateforme à une autre.

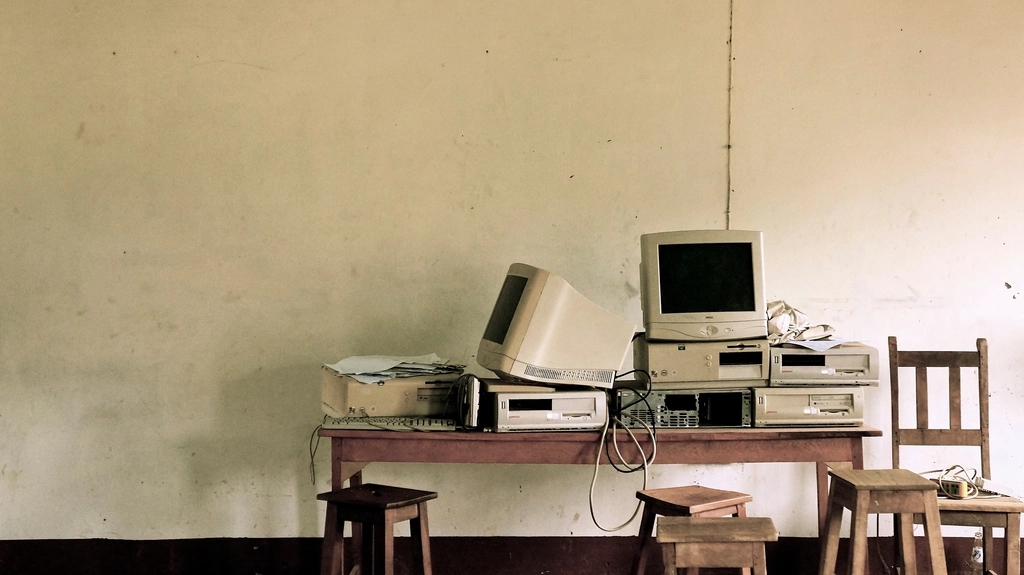

Bien sûr, l’ordinateur de la fin de la décennie n’avait plus rien à voir avec celui du début. Le nombre de transistors avait été multiplié par 20 en une décennie. Et la fréquence de calcul était au minimum décuplée. La loi de Moore se vérifiait sans difficulté. Cela pouvait causer une incompréhension pour l’acheteur.

Acheter un ordinateur à un prix élevé pour le voir dépassé 2 ans plus tard, cela n’aidait pas à se projeter. Les usages évoluant très vite grâce au talent des programmeurs, le logiciel capable de déclencher l’achat serait-il maintenu sur la machine récemment acquise ? Le constructeur existerait-il encore ?

Le domaine informatique dans les années 80 était un terrain d’expérimentation. La framboise magique est l’aboutissement de la logique de Lord Sinclair, un ordinateur peu cher pour apprendre l’informatique à tous. Bien que philosophiquement opposés, les produits d’Apple ont retrouvé le succès.

Les systèmes d’exploitation sont toujours offerts avec les ordinateurs et gardent le public captif des suites logicielles. Une chose a cependant changé : l’arrivée d’Internet. Il aurait été une passerelle formidable pour rapprocher les différentes plateformes. Mais on ne refait pas l’histoire.

En tout cas, me replonger dans cette époque m’a permis de prendre du recul. Il fallait être motivé pour programmer sur de telles machines. Le manque de mémoire n’a pas empêché l’émergence de jeux exceptionnels et de logiciels révolutionnaires. Les développeurs faisaient l’effort de comprendre leur machine.

Les décennies suivantes ont aussi eu leurs lots d’évolutions. Les µp sont toujours plus puissants et les ordinateurs sont désormais partout. Les langages se sont multipliés. Il serait bien que nos responsables évoluent aussi et ne restent pas bloqués dans les années 80.

Savoir d’où on vient, cela permet de ne pas reproduire les erreurs …